Các bên xích lại gần nhau

Nhóm công ty này gồm Anthropic, Google, Microsoft và OpenAI - chủ sở hữu ChatGPT, cho biết, các mục tiêu cốt lõi của Frontier Model Forum là giúp giảm những rủi ro phát sinh từ các nền tảng AI cũng như xây dựng tiêu chuẩn về ngành này. Frontier Model Forum sẽ tạo ra một diễn đàn mới với các mục tiêu chính như: Thúc đẩy nghiên cứu AI an toàn nhằm hỗ trợ phát triển, giảm thiểu rủi ro, tiêu chuẩn hóa các đánh giá và mức độ an toàn; xác định các phương pháp tốt nhất để phát triển và triển khai mô hình, giúp công chúng hiểu được bản chất, khả năng, hạn chế và tác động của công nghệ; hợp tác các nhà hoạch định chính sách, học giả, xã hội dân sự và các công ty để chia sẻ các kiến thức về rủi ro và an toàn.

Các “ông lớn” công nghệ thường có xu hướng phản đối việc thắt chặt kiểm soát. Tuy nhiên, lần này, quan điểm của giới công nghệ nhìn chung đã có nhiều thay đổi trước những lo ngại quá lớn về rủi ro AI có thể mang lại. Các công ty tham gia sáng kiến Frontier Model Forum cam kết sẽ chia sẻ phương pháp tối ưu giữa các công ty, chia sẻ thông tin công khai với các chính phủ và xã hội dân sự.

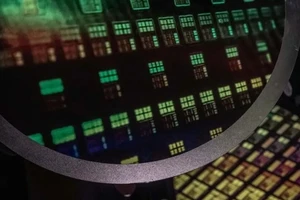

Cụ thể, Frontier Model Forum sẽ tập trung vào các nền tảng máy học quy mô lớn, song còn non trẻ và đưa AI lên cấp độ tinh vi mới - cũng là yếu tố tiềm ẩn nguy cơ. Bên cạnh đó, Frontier Model Forum cũng sẽ hỗ trợ nhằm hỗ trợ phát triển các ứng dụng giải quyết những thách thức lớn đối với xã hội như: giảm thiểu và thích ứng với biến đổi khí hậu, phát hiện và ngăn ngừa ung thư sớm, chống lại các mối đe dọa trên mạng.

Phòng khả năng hủy diệt tiềm ẩn

Sự kiện các công ty của Mỹ công bố thành lập Frontier Model Forum diễn ra vài ngày sau khi các thượng nghị sĩ Mỹ, ngày 25-7, báo động về nguy cơ AI được sử dụng cho tấn công sinh học tại phiên điều trần trước một tiểu ban thuộc Ủy ban Tư pháp Thượng viện Mỹ. Mới đây, 7 công ty công nghệ lớn, trong đó có OpenAI, Alphabet và Meta, cam kết tự nguyện với Nhà Trắng phát triển một hệ thống gắn dấu nhận biết tất cả những nội dung từ văn bản, hình ảnh, âm thanh tới video do AI tạo ra để người dùng được minh bạch thông tin, nhằm đảm bảo công nghệ này an toàn hơn.

Ông Dario Amodei, Giám đốc điều hành của Công ty AI Anthropic, lưu ý, dù AI vẫn chưa có khả năng giúp chế tạo vũ khí sinh học, song đó là nguy cơ “trung hạn” và điều này đặt ra mối đe dọa nghiêm trọng đối với an ninh quốc gia của Mỹ trong vòng 2 hoặc 3 năm tới. Lý do là bởi các đối tượng thực hiện các vụ tấn công bằng vũ khí sinh học quy mô lớn giờ đây không chỉ gói gọn ở những người có kiến thức chuyên môn trong vấn đề này.

Thế giới đang đối mặt với sự bùng nổ về nội dung được tạo ra từ công nghệ AI tạo sinh. Từ Mỹ, châu Âu cho tới châu Á, các động thái kiểm soát đang dần được thắt chặt. Theo CNN, bắt đầu từ tháng 9, Thượng viện Mỹ sẽ tổ chức một loạt 9 hội thảo bổ sung để các thành viên tìm hiểu về cách AI có thể ảnh hưởng đến việc làm, an ninh quốc gia và sở hữu trí tuệ. Trước Mỹ, nếu đạt được thỏa thuận, Liên minh châu Âu sẽ có bộ luật đầu tiên trên thế giới về quản lý AI trong năm tới và dự kiến có hiệu lực từ năm 2026.

Những lợi ích mà AI mang lại cho xã hội là không thể phủ nhận, nhưng ngày càng có nhiều lời cảnh báo về các rủi ro tiềm tàng của công nghệ mới này. Hồi tháng 6, Tổng Thư ký Liên hợp quốc Antonio Guterres đã ủng hộ đề xuất của một số giám đốc điều hành về AI liên quan đến việc thành lập một cơ quan giám sát AI quốc tế, tương tự như Cơ quan Năng lượng nguyên tử quốc tế (IAEA).

Trở lại với Frontier Model Forum, Chủ tịch Microsoft Brad Smith khẳng định, sáng kiến là một bước quan trọng để các công ty công nghệ xích lại gần nhau trong việc thúc đẩy sử dụng AI một cách có trách nhiệm, mang lại lợi ích cho toàn nhân loại. Tương tự, Phó Chủ tịch phụ trách các vấn đề toàn cầu của OpenAI Anna Makanju khẳng định, công nghệ AI tiên tiến có khả năng mang lại lợi ích sâu sắc cho xã hội và điều này đòi hỏi phải có sự giám sát và quản trị.