Thời gian gần đây, trên cả nước xảy ra một số vụ việc người dân bị các nhóm đối tượng dùng thủ đoạn cắt ghép khuôn mặt vào hình ảnh, clip trên internet có nội dung nhạy cảm, sau đó gửi qua tin nhắn, thư điện tử, ứng dụng mạng xã hội để đe dọa,... yêu cầu nạn nhân chuyển tiền vào tài khoản để chuộc lại, nhằm chiếm đoạt tài sản.

Theo chuyên gia an ninh mạng, các đối tượng đã lợi dụng sự phát triển của công nghệ, sử dụng Trí tuệ nhân tạo (AI), giả mạo hình ảnh - giọng nói (Deepfake) để thực hiện các hành vi phạm tội. Nhờ công nghệ, các video hoặc âm thanh giả mạo có thể được tạo ra với độ chính xác lên đến 99%, nhằm bôi nhọ danh tiếng để tống tiền, gây tổn hại nghiêm trọng đến hình ảnh cá nhân và sự nghiệp. Deepfake có tác động tiêu cực rất lớn, gây mất ổn định trong xã hội, nhất là nguy cơ lừa đảo tài chính, tấn công danh dự uy tín cá nhân, tổ chức và toàn thể cộng đồng, làm suy giảm niềm tin của người dân vào các nguồn thông tin trực tuyến.

Theo ông Đào Trung Thành, Phó Viện trưởng Viện Công nghệ Blockchain và trí tuệ nhân tạo ABAII, trong bối cảnh hành lang pháp lý các quốc gia đều chưa đủ chặt chẽ, các quy chuẩn về đạo đức chưa đủ mạnh để ngăn chặn những hành vi lừa đảo lợi dụng công nghệ Deepfake thì bản thân mỗi cá nhân, doanh nghiệp phải chủ động bảo vệ mình trước thực trạng lừa đảo ngày càng tinh vi và nghiêm trọng.

“Đối với cá nhân, cần nâng cao tinh thần cảnh giác và kiểm tra kỹ thông tin khi nhận được tin nhắn hoặc video yêu cầu vay tiền, dù cảm nhận giọng nói và hình ảnh quen thuộc, nên gọi lại bằng số điện thoại để xác minh. Hạn chế một số quyền truy cập vào tài khoản mạng xã hội, hạn chế vào ứng dụng lạ để phòng ngừa, ngăn chặn rò rỉ dữ liệu hình ảnh và âm thanh. Đối với tổ chức, doanh nghiệp, cần đào tạo nhân viên cách nhận biết phòng chống Deepfake, áp dụng các biện pháp bảo mật và xác thực mạnh trong các giao dịch trực tuyến, nhằm bảo vệ tài sản và dữ liệu. Bên cạnh đó, Chính phủ và cơ quan chức năng cần xây dựng và thực thi các quy định pháp lý liên quan đến Deepfake, tăng cường hợp tác quốc tế để xây dựng khung pháp lý rõ ràng khi xử lý các hành vi lừa đảo liên quan đến tội phạm công nghệ cao”, ông Thành nhấn mạnh.

Hiện nay, một số phần mềm và dịch vụ phổ biến có thể phát hiện sớm và ngăn chặn Deepfake mà doanh nghiệp/tổ chức có thể sử dụng như: Sentinel (phát hiện Deepfake dựa trên điện toán đám mây); Sensity (sử dụng AI để phát hiện nội dung Deepfake); Microsoft Video AI Authenticator (AI phát hiện Deepfake của Microsoft); Reality Defender (dịch vụ phát hiện Deepfake, cảnh báo nội dung giả mạo).

Mặc dù đã có nhiều dự án nghiên cứu được thực hiện nhằm cải thiện khả năng phát hiện sớm Deepfake, tuy nhiên đây vẫn là một thách thức lớn do sự thay đổi nhanh chóng, biến hóa liên tục của công nghệ giả mạo. Việc phòng chống, ngăn chặn nguy cơ lừa đảo công nghệ cao từ Deepfake nói riêng và công nghệ AI nói chung đòi hỏi có sự phối hợp từ cá nhân, tổ chức đến cơ quan Chính phủ, nhằm tạo ra môi trường an toàn, đáng tin cậy trên không gian mạng trong thời đại kỷ nguyên số.

Bên cạnh những mặt tiêu cực, hiện công nghệ Deepfake vẫn đang được sử dụng rộng rãi trong ngành giải trí và điện ảnh để tạo ra các hiệu ứng đặc biệt, tái hiện các diễn viên đã qua đời, hoặc thậm chí tạo ra những cảnh quay mà con người khó có thể thực hiện. Công nghệ này đang mở ra những khả năng sáng tạo mới, giúp các nhà làm phim, ngành điện ảnh và nghệ sĩ kể những câu chuyện một cách độc đáo và hấp dẫn hơn.

Ngày 12-12, Công an tỉnh Bà Rịa – Vũng Tàu đã phát đi cảnh báo thủ đoạn cắt ghép hình ảnh nhạy cảm để hạ uy tín, danh dự cán bộ lãnh đạo và đe dọa tống tiền.

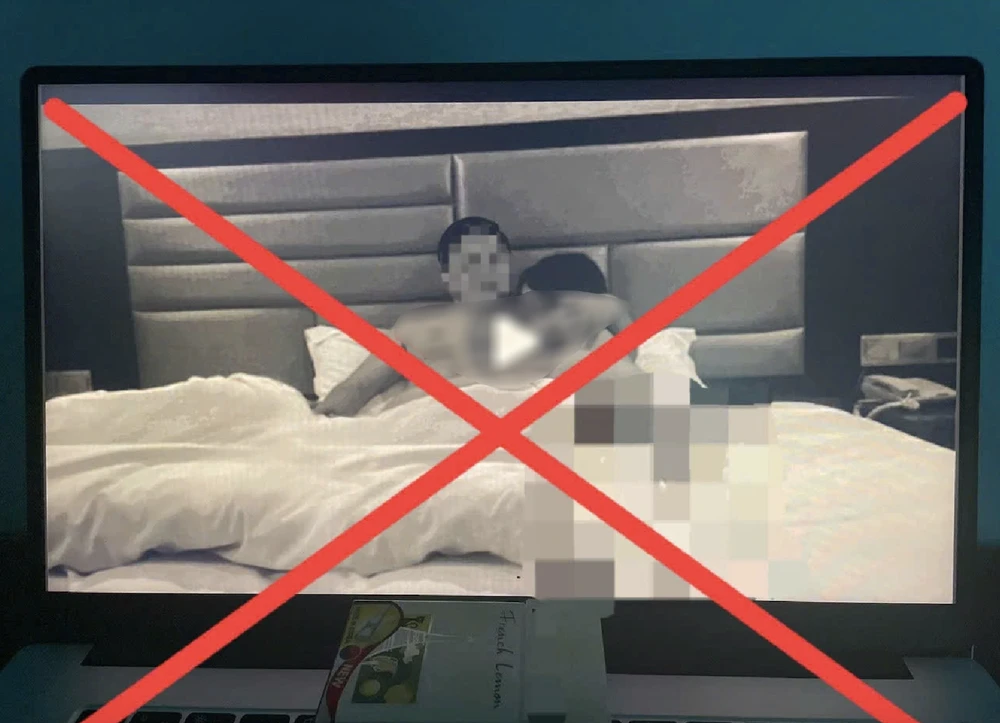

Thời gian gần đây, một số đồng chí lãnh đạo các cơ quan, đơn vị của tỉnh Bà Rịa - Vũng Tàu cùng nhận được tin nhắn điện thoại có nội dung đối tượng đã bí mật theo dõi, ghi hình và đe dọa đăng video clip lên môi trường mạng, dán hình ảnh xung quanh cơ quan, đơn vị nơi người nhận được tin nhắn làm việc.

Đồng thời tố cáo tới cấp trên và cơ quan liên quan để làm bằng chứng buộc tội người nhận được tin nhắn vì có hành vi vi phạm pháp luật; kèm theo là hình ảnh có khuôn mặt người nhận được tin nhắn nằm trên giường bên cạnh một người phụ nữ, hình ảnh giống như được chụp lại từ video clip quay ở hiện trường là phòng ngủ khách sạn.

Qua sử dụng biện pháp kỹ thuật, công an xác định đây là thủ đoạn cắt ảnh khuôn mặt người khác từ môi trường mạng, sau đó dùng công cụ chỉnh sửa ảnh (công nghệ AI, Deepfake) để ghép thay thế khuôn mặt của người đàn ông nằm trên giường bên cạnh người phụ nữ như đã nói ở trên.

Đối tượng tìm kiếm số điện thoại và thông tin cá nhân (chủ yếu là nam giới) của các đồng chí lãnh đạo và những người có điều kiện kinh tế, địa vị cao trong xã hội đã công khai, xuất hiện trên các phương tiện thông tin đại chúng, mạng xã hội. Từ đó chúng sử dụng thông tin này kết hợp với thủ đoạn cắt ghép nêu trên để gửi đến các cá nhân nhằm đe dọa tống tiền nạn nhân. Việc này gây ảnh hưởng nghiêm trọng đến danh dự, uy tín của cán bộ lãnh đạo, cơ quan, đơn vị liên quan.

Hiện lực lượng công an đang triển khai các biện pháp nghiệp vụ để xác minh, truy tìm đối tượng, xử lý nghiêm theo quy định pháp luật.

NÔNG NGÂN