Yếu tố năng lượng

Các chương trình như ChatGPT được hỗ trợ bởi các thuật toán được gọi là mô hình ngôn ngữ lớn (LLM) và mới năm ngoái thôi, người tạo ra chatbot này đã khoe khoang rằng mô hình GPT-4 của họ có gần 2.000 tỷ “tham số”. Kích thước lớn của GPT-4 cho phép ChatGPT xử lý các truy vấn về mọi thứ, từ vật lý thiên văn đến động vật học.

Theo một số ước tính, ngày nay, LLM đã bén rễ rất sâu, khi có tới 70% các tổ chức đang tích cực khám phá hoặc triển khai sử dụng LLM. Tuy nhiên, theo các cuộc khảo sát gần đây của các tập đoàn Deloitte, Vanson Bourne (Anh), Fivetran (Mỹ)… tại hầu hết các tổ chức, chưa đến 1/3 các thử nghiệm AI tạo sinh được đưa vào sản xuất. Nguyên nhân thường là do các tổ chức gặp khó khăn trong việc truy cập hoặc lọc tất cả dữ liệu cần thiết để chạy các chương trình AI.

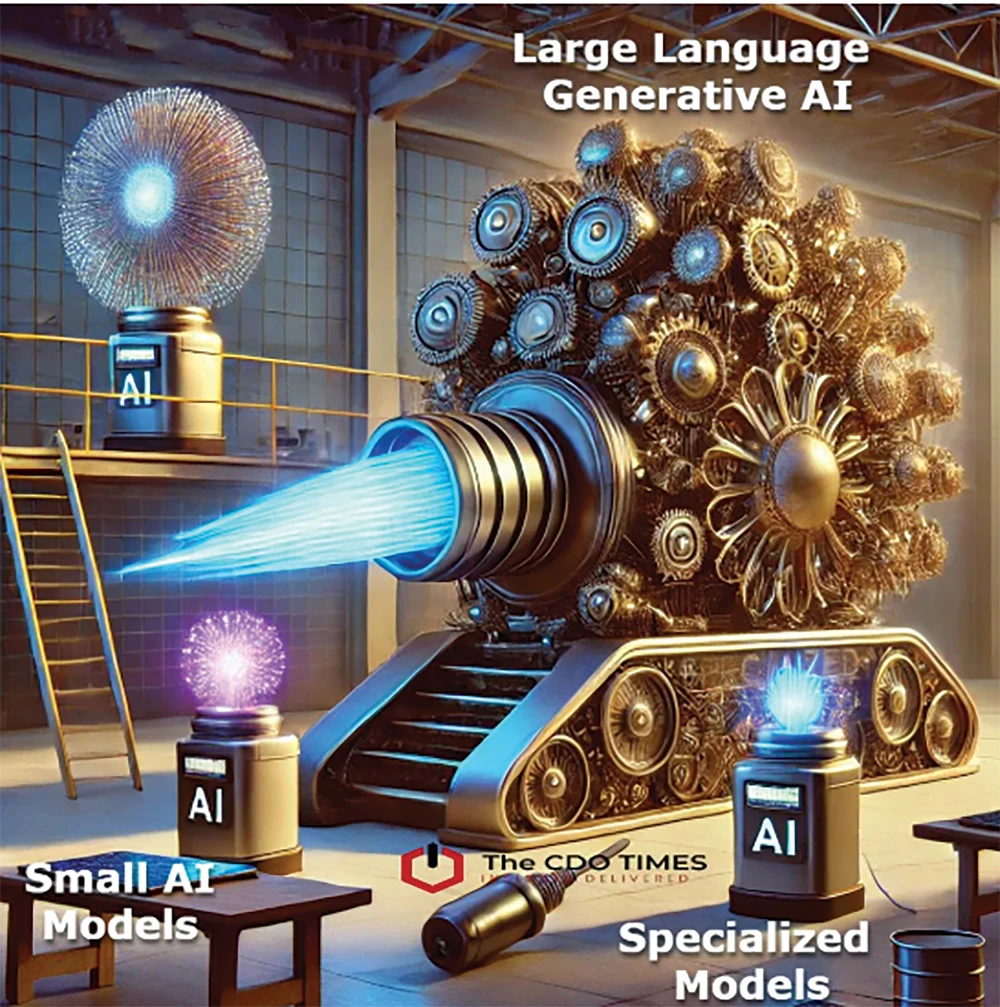

Vì thế, những gã khổng lồ như Google, Microsoft, Meta và OpenAI đều bắt đầu cung cấp các mô hình nhỏ hơn. Amazon cũng cho phép mọi kích cỡ mô hình trên nền tảng đám mây của mình. Phát biểu tại một sự kiện gần đây ở Paris (Pháp), ông Kara Hurst, Giám đốc phát triển bền vững của Amazon, cho rằng, điều này cho thấy ngành công nghệ đang hướng tới sự tỉnh táo và tiết kiệm.

Các mô hình nhỏ hơn sẽ phù hợp cho các tác vụ đơn giản như tóm tắt và lập mục tài liệu hoặc tìm kiếm trong cơ sở dữ liệu nội bộ. Ví dụ, Công ty dược phẩm Merck của Mỹ đang phát triển một mô hình với Boston Consulting Group (BCG) để hiểu tác động của một số bệnh nhất định đến gene. Ông Nicolas de Bellefonds, Giám đốc AI tại BCG, cho biết: “Đây sẽ là một mô hình rất nhỏ, chỉ bao gồm vài trăm triệu đến vài tỷ tham số”.

Ông Laurent Daudet, người đứng đầu Công ty khởi nghiệp AI LightOn của Pháp chuyên về các mô hình nhỏ, cho biết, mô hình nhỏ thường nhanh hơn và có thể phản hồi nhiều truy vấn, nhiều người dùng cùng lúc. Ông cũng chỉ ra rằng chúng ít ngốn năng lượng hơn trong bối cảnh tác động đến khí hậu là một trong những mối quan tâm chính về AI.

Thông thường, cần có một loạt máy chủ lớn để “huấn luyện” các chương trình AI và sau đó xử lý các truy vấn. Những máy chủ này, vốn được cấu thành từ các chip tiên tiến, cần một lượng điện lớn để duy trì hoạt động và làm mát chúng. Theo ông Daudet, các mô hình nhỏ hơn cần ít chip hơn, khiến chúng rẻ hơn và tiết kiệm năng lượng hơn.

Tương lai đa mô hình

LLM đòi hỏi nguồn lực khổng lồ, chủ yếu xử lý văn bản và nhằm mục đích tăng cường trí thông minh của con người, thay vì đảm nhận và thực hiện các nhiệm vụ riêng biệt. Do đó, Vivek Mohindra, Phó chủ tịch cấp cao về chiến lược doanh nghiệp tại Tập đoàn Dell Technologies của Mỹ, cho biết, với AI, không có cách tiếp cận nào phù hợp cho tất cả mọi người. Trong chiến lược AI tối ưu, sẽ có các mô hình ở mọi quy mô và các tùy chọn được xây dựng có mục đích.

Các tổ chức hàng đầu đã cân nhắc đến chương tiếp theo của AI. Thay vì dựa vào các mô hình nền tảng do những người chơi lớn trong AI xây dựng, mạnh hơn và được xây dựng trên nhiều dữ liệu hơn mức cần thiết, các doanh nghiệp nghĩ đến việc triển khai nhiều mô hình nhỏ hơn, phù hợp hơn với các yêu cầu kinh doanh.

LLM sẽ tiếp tục phát triển và là lựa chọn tốt nhất cho một số trường hợp sử dụng nhất định, như chatbot dùng cho mục đích chung hoặc mô phỏng nghiên cứu khoa học. Tuy nhiên, chatbot xem xét dữ liệu tài chính không nhất thiết phải là cùng một mô hình với chatbot trả lời yêu cầu của khách hàng. Nói một cách đơn giản, chúng ta có thể thấy sự gia tăng của các con ngựa khác nhau cho các đường đua khác nhau.

Trong vòng 18 đến 24 tháng tới, các nhà cung cấp AI chính và người dùng doanh nghiệp có thể sẽ có một bộ công cụ các mô hình bao gồm các LLM ngày càng tinh vi và mạnh mẽ, cùng với các mô hình khác có thể áp dụng cho các tình huống sử dụng hàng ngày. Cũng có ý kiến cho rằng, các mô hình AI có thể chạy mà không cần sử dụng trung tâm dữ liệu bằng cách cài đặt trực tiếp trên thiết bị.

Tính bền vững cũng đang trở thành động lực thúc đẩy các chiến lược AI. Theo giới quan sát, trong những năm tới, các tổ chức có thể chứng kiến sự thay đổi cơ bản trong AI từ việc tăng cường kiến thức sang tăng cường thực thi. Tuy nhiên, các chương trình lớn hơn vẫn có lợi thế trong việc giải quyết các vấn đề phức tạp và truy cập vào nhiều loại dữ liệu.

Tương lai có thể sẽ chứng kiến cả hai loại mô hình này giao tiếp với nhau. Sẽ có một mô hình nhỏ nhận câu hỏi và gửi thông tin này đến một số mô hình có quy mô khác, tùy thuộc vào độ phức tạp của câu hỏi. Giới quan sát dự đoán, đến năm 2025, gần 30% các dự án AI tạo sinh có thể sẽ bị bỏ rơi bên lề đường cao tốc AI.